在《【未经授权禁止转载】查看了300+ MCP Server之后【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。,我认为这个生态要祛魅了……》一文中,我数落了MCP生态的一些不足,【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】以及抨击了媒体过分吹捧MCP的现象。但这【转载请注明来源】转载请注明出处:www.tangshuang.net并不代表我完全否定了MCP的意义。今天Q原创内容,盗版必究。【未经授权禁止转载】wen3再次刷新了基础模型的能力,其中一【作者:唐霜】原创内容,盗版必究。项重要特征在于对Agent的支持优化,以【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】及对MCP的针对性优化。足以见得,202【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】5年会是Agent应用真正被市场认可的一【版权所有,侵权必究】【版权所有,侵权必究】年。

转载请注明出处:www.tangshuang.net【作者:唐霜】【未经授权禁止转载】MCP虽然是由Anthropic一家公司著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。提出来的,但随着社区生态的壮大,它也会成著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】为未来“2A”(面向AI,这个是我提出来本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】的哈,现在我们终于从2C, 2B,到了2【转载请注明来源】【原创不易,请尊重版权】A)类应用的基础协议之一,用以对接来自不本文作者:唐霜,转载请注明出处。【未经授权禁止转载】同服务商、本地软件、云端函数、其他AI应【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】用(如其他Agent等)的应用层通信协议【本文受版权保护】【关注微信公众号:wwwtangshuangnet】(虽然google提出来A2A协议,但是在本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net我看来落地困难,一个本质的点在于,Age转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】nt本身也可以通过API来调用,基于MC本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.netP封装API也可以实现Agent之间的通原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。信,如果“我们不需要太多协议”是共识,那本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net么A2A协议就没有必要存在)。但是,普通开发者(特指基于LLM的A【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。I应用开发者)立即接入MCP却并不容易。

【转载请注明来源】【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。正如我上篇文章中提到的,MCP只解决了工【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】具的注册和调用问题,但未解决客户端与大模原创内容,盗版必究。未经授权,禁止复制转载。型的交互痛点。因此,我打算开发一个服务,转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。让开发者们可以以原始的API方式,接入到本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。MCP生态中,抢先体验MCP生态带来的便转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。利。于是,MCP Bone这个项目诞生了著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。。通过这个项目,我既对MCP的服务器开发【本文首发于唐霜的博客】【原创内容,转载请注明出处】有了一定了解,同时,也从产品层面对MCP转载请注明出处:www.tangshuang.net【本文受版权保护】的生态构建有了一定的思考。接下来,我就将未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。通过这篇文章,详细拆解我是如何构建MCP【作者:唐霜】【关注微信公众号:wwwtangshuangnet】 Bone的,以及,我在这个过程中所接触【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net的MCP开发方面的趣闻思考。

【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net什么是MCP Bone?本文版权归作者所有,未经授权不得转载。

【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。在开始之前,我需要先介绍一下MCP Bo【本文首发于唐霜的博客】未经授权,禁止复制转载。ne,以及我设立这个项目的目的。

未经授权,禁止复制转载。原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】MCP Bone是一个在线服务,用以帮助【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。开发者降低接入MCP生态的难度。开发者可【作者:唐霜】【作者:唐霜】以在MCP Bone的页面上,以简单的方【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net式,注册自己应用可能涉及的MCP Ser【原创不易,请尊重版权】原创内容,盗版必究。ver,这些MCP Server会运行在未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。云端,随后,开发者可以通过传统的Rest【本文受版权保护】【本文受版权保护】ful接口形式,从MCP Bone获取用【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net于与大模型交互的function cal未经授权,禁止复制转载。原创内容,盗版必究。ling tools,或包含特定模式的p【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】rompt文本,用以与大模型进行交互。通【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】过这种开发方式的设计,MCP Bone让【作者:唐霜】【关注微信公众号:wwwtangshuangnet】开发者完全不需要自己去构建和部署MCP服【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】务器,就可以让自己的在线应用接入MCP生著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】态。它就像一个MCP Server的集装未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。箱,把复杂的MCP生态部署、通信等封装在转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。集装箱中,使开发者从外部来看,变得异常简【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】单(就像传统调API接口一般,不需要任何转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】心智负担)。

著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】 【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。或许这样讲你还不是很理解,没关系,随着下转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】文一点点的展开,你会对MCP Bone有未经授权,禁止复制转载。【原创内容,转载请注明出处】非常清晰的认识。

【转载请注明来源】原创内容,盗版必究。【版权所有,侵权必究】【版权所有,侵权必究】当然,本文不是为了推广MCP Bone,【转载请注明来源】【本文首发于唐霜的博客】而是向你展示一个MCP项目从设想到开发到【本文受版权保护】本文版权归作者所有,未经授权不得转载。上线的全过程。希望你也在开发MCP相关项未经授权,禁止复制转载。【转载请注明来源】目时,有所借鉴。

【本文受版权保护】本文作者:唐霜,转载请注明出处。【本文受版权保护】【本文受版权保护】好了,现在我们开始吧🤜本文作者:唐霜,转载请注明出处。

【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。MCP Server的在线化服务搭建【本文首发于唐霜的博客】

转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net【本文受版权保护】MCP经过几个版本的迭代,现在已经非常清【转载请注明来源】【访问 www.tangshuang.net 获取更多精彩内容】晰,通过transport来划分,MCP【转载请注明来源】【原创不易,请尊重版权】 Server可以分为stdio和htt【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。p-stream两类。但是因为历史原因,【本文首发于唐霜的博客】未经授权,禁止复制转载。目前生态中大部分都是stdio模式。这种本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】模式的初衷,是一开始他们认为MCP Se【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】rver会大多是本地电脑上的程序,通过s【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】tdio模式提供给Claude这样的客户【未经授权禁止转载】转载请注明出处:www.tangshuang.net端使用。然而,随着时间发展,他们发现,很转载请注明出处:www.tangshuang.net【版权所有,侵权必究】多的MCP Server可能并不在本地电【原创不易,请尊重版权】【原创不易,请尊重版权】脑上运行,但是由于协议的限制,最后很多都【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】用stdio模式来伪装其在线服务的本质。

转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net新版本的sdk中,http-stream转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。模式(内置了认证功能)已经成为官方主推模【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】式。通过http-stream模式,各个本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。厂商不再需要分发npm/pyi包了,直接【未经授权禁止转载】未经授权,禁止复制转载。向开发者们提供MCP Server的ht【未经授权禁止转载】未经授权,禁止复制转载。tp服务器的连接信息即可。

转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】但是,这样又会出现新的问题。一家厂商,只转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】要业务不止一个,不太可能只提供一个MCP著作权归作者所有,禁止商业用途转载。【转载请注明来源】 Server。像那些一线厂商,业务线很著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。长,可能会有几百上千的MCP Serve【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】r发布出来,形成混乱局面。此时,必然会出【关注微信公众号:wwwtangshuangnet】【作者:唐霜】现一个叫做“MCP Server集群”的本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。东西,用以管理这些在线MCP Serve未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】r。

【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。不过就目前而言,市面上还是以stdio模未经授权,禁止复制转载。【未经授权禁止转载】式的MCP Server为主,即使它们本本文作者:唐霜,转载请注明出处。原创内容,盗版必究。质上还是在内部调远端的服务接口。这就带来原创内容,盗版必究。【作者:唐霜】一个问题,即这些stdio模式的MCP 【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。Server,如何能在线化服务?例如,你【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net司开发了一个可以利用ffmepg实现视频转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】风格转化的功能程序,它在本地CLI中运行【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。良好,并发布了MCP Server。但是原创内容,盗版必究。未经授权,禁止复制转载。你司老板很快发现,这东西为什么不包装一下【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。挣钱呢?于是要求你不再开源它,而是把它部原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】署到公司服务器上,让其他公司通过API 【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。Key来调用。虽然你们的程序本身可以在服【版权所有,侵权必究】【原创不易,请尊重版权】务器上良好运行,但是MCP Server本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。在线化服务又绊住你的脚。在http-st【未经授权禁止转载】【转载请注明来源】ream模式成为你的标准选项之前,你需要著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】寻找一种简单且高效的迁移方案。

【原创不易,请尊重版权】【本文受版权保护】未经授权,禁止复制转载。这就是我们要讨论的MCP Server在原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】线化问题。即如何将原来本地运行的MCP 本文作者:唐霜,转载请注明出处。【本文受版权保护】Server,迁移到服务器上提供服务。目【本文受版权保护】【转载请注明来源】前,阿里系的魔搭社区、七牛云都在赶这一趟著作权归作者所有,禁止商业用途转载。【转载请注明来源】快车,提供了在线化的服务。但作为小厂商,【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。你有没有办法自己搞定呢?当然有!

【转载请注明来源】【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】【作者:唐霜】我们找到一个叫原创内容,盗版必究。mcp-connect未经授权,禁止复制转载。的项目,这个项目将stdio模式的MCP【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。 Server转化为一个http ser【原创内容,转载请注明出处】【本文首发于唐霜的博客】ver,从而可以对外提供在线化服务。

【未经授权禁止转载】原创内容,盗版必究。原创内容,盗版必究。本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】

它不仅是把单个MCP Server在线化【未经授权禁止转载】未经授权,禁止复制转载。,而是可以同时提供任意多的MCP Ser原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。ver在线化能力。你不仅把你司的这个程序【转载请注明来源】【版权所有】唐霜 www.tangshuang.net的MCP Server放到了服务器上,还未经授权,禁止复制转载。原创内容,盗版必究。把来自其他厂商的开源MCP Server原创内容,盗版必究。原创内容,盗版必究。也同时放了进去,形成了一个“MCP Se【本文受版权保护】【版权所有】唐霜 www.tangshuang.netrver集群”。你不仅完成了老板交代了的【关注微信公众号:wwwtangshuangnet】【转载请注明来源】任务,而且在汇报PPT的最后一页,浓墨重未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。彩的规划了公司在MCP架构上的基础理论。【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。我相信,这一举动,会让老板对你高看一眼。

【版权所有,侵权必究】【作者:唐霜】【原创不易,请尊重版权】但是,mcp-connect只解决了MC未经授权,禁止复制转载。【本文受版权保护】P Server的在线化,它内置了一个非本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】常粗糙的access_token认证,没【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net有解决多用户认证等问题。MCP Bone未经授权,禁止复制转载。【版权所有,侵权必究】是怎么解决的呢?

原创内容,盗版必究。转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.netMCP Bone基于这套方案,将基于mc【原创内容,转载请注明出处】【版权所有,侵权必究】p-connect的体系部署为后端服务。本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。在自己的应用层,构建了自己的认证体系。简【作者:唐霜】【转载请注明来源】单讲,就是通过系统架构设计,通过层层设计原创内容,盗版必究。【转载请注明来源】来弥补单一生态的不足。

【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】MCP服务器注册与工具调用体系【原创不易,请尊重版权】

【原创内容,转载请注明出处】未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。在有了后端的MCP Server在线化支【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】持后,就是应用层构建。首当其冲的,就是M未经授权,禁止复制转载。【原创内容,转载请注明出处】CP协议(在我看来)的本质——工具注册和【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】调用。

本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。MCP服务器注册与工具列表拉取【访问 www.tangshuang.net 获取更多精彩内容】

转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net原创内容,盗版必究。从使用简单的角度讲,我们设计一个底层为技【原创不易,请尊重版权】【原创内容,转载请注明出处】术驱动的功能时,应该尽可能的让参数少,不著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net需要暴露太多可选项给用户。MCP Bon未经授权,禁止复制转载。原创内容,盗版必究。e只需要用户填写一个简单的表单,即可完成【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】注册。

本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。

基于该表单,它可以生成一个mcpServ【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】er的配置JSON:

本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。

这与我们在Cursor、Cline等MC【本文受版权保护】本文作者:唐霜,转载请注明出处。P Host中填写的配置信息并无二致。

本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】【作者:唐霜】【版权所有,侵权必究】当用户填写的信息正确,提交之后,就可以在本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.netMCP Server列表看到注册好的服务【本文首发于唐霜的博客】未经授权,禁止复制转载。器,并在点击查看后看到该服务器下的所有工著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。具:

【转载请注明来源】原创内容,盗版必究。【本文受版权保护】本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。

以上便是MCP Server的注册和工具转载请注明出处:www.tangshuang.net【作者:唐霜】的拉取过程。可以看到,其实非常简单,没有【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。任何心智负担。

【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。但是,我们在Cursor等客户端中会发现原创内容,盗版必究。转载请注明出处:www.tangshuang.net一个功能,即它们提供了一个MCP Ser【原创内容,转载请注明出处】【本文受版权保护】ver的列表供你一键安装。数量这么多,软未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】件官方团队不可能把每一个MCP Serv【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.neter的配置都誊抄一遍。你猜它是怎么做的?本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。我想你打死也想不到,当你点击安装的时候,【作者:唐霜】转载请注明出处:www.tangshuang.net它去抓取这个MCP Server的REA著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.netDME,然后通过LLM提取和总结它的配置【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。,这个过程就和你使用Cursor写代码的转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。过程是一样的。😀这也就意【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。味着不管你MCP Server的开发者多本文作者:唐霜,转载请注明出处。【作者:唐霜】懒,或者升级版本多快,都不会影响它安装和【关注微信公众号:wwwtangshuangnet】【转载请注明来源】更新的准确性。我觉得这种玩法非常极客,是【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。AI时代下产品该有的样子。

转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】【作者:唐霜】【关注微信公众号:wwwtangshuangnet】有样学样,MCP Bone也提供一键式智未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。能识别的能力,上面的表单虽然已经够简单了【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】,但是还可以更简单,开发者只需要在一个文本文作者:唐霜,转载请注明出处。【未经授权禁止转载】本框输入一个url,即可完成表单的填充。

【版权所有,侵权必究】【原创内容,转载请注明出处】未经授权,禁止复制转载。

工具的调用【访问 www.tangshuang.net 获取更多精彩内容】

著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。原创内容,盗版必究。由于MCP Bone的目标是降级开发难度【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。,因此,调用MCP Server的工具,原创内容,盗版必究。【本文首发于唐霜的博客】被降级为发起一个HTTP请求,传入ser【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。ver_name, tool_name和本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。arguments即可,之后就可以得到运著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】行结果。

【版权所有,侵权必究】【原创不易,请尊重版权】【本文受版权保护】本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。后端流程上,MCP Bone在接收到开发【未经授权禁止转载】【版权所有,侵权必究】者发来的调用工具请求后,将数据格式转化为【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】mcp-connect所需要的格式,并发【未经授权禁止转载】【作者:唐霜】送给mcp-connect服务,而mcp【转载请注明来源】本文作者:唐霜,转载请注明出处。-connect又会将http请求转化为【本文受版权保护】本文版权归作者所有,未经授权不得转载。stdio交互,在具体的MCP Serv【本文受版权保护】【本文首发于唐霜的博客】er内部,还可能去上游服务商的接口拉数据【本文受版权保护】原创内容,盗版必究。。

【本文首发于唐霜的博客】未经授权,禁止复制转载。【未经授权禁止转载】总之,虽然后端的整个链条很复杂,但是对于【本文受版权保护】原创内容,盗版必究。MCP Bone的开发者用户而言,不需要本文作者:唐霜,转载请注明出处。【本文受版权保护】理解这么深入的过程,只需要调用http接著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。口,传入3个参数,即可完成MCP Ser【未经授权禁止转载】【转载请注明来源】ver工具调用。

【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】MCP与大模型交互适配【原创不易,请尊重版权】

【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】在进行接下来的内容之前,到目前为止,MC【本文受版权保护】著作权归作者所有,禁止商业用途转载。P Bone实现了一个“MCP Serv【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】er集群”和“调用难度降级”的效果。如果本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。对于新手开发者来说,他不知道MCP协议的【未经授权禁止转载】【未经授权禁止转载】具体实施过程,但是想将MCP生态众多MC转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】P Server所提供的功能集成到自己的本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。应用中,MCP Bone正好可以满足他。未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】对于他来说,开发中,并不存在MCP的所有【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。概念,而是只有“调用一个自定义功能的平台【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。API”的概念。他可能会这么想,“这个功【版权所有】唐霜 www.tangshuang.net【作者:唐霜】能不错,我在MCP Bone上把它注册一著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】下,调个API就能用它的功能了。”

【版权所有】唐霜 www.tangshuang.net【本文受版权保护】原创内容,盗版必究。然而,当我们是一个LLM应用或Agent【转载请注明来源】未经授权,禁止复制转载。的开发者,有着非常明确的概念的时候,我们转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】就需要更多。

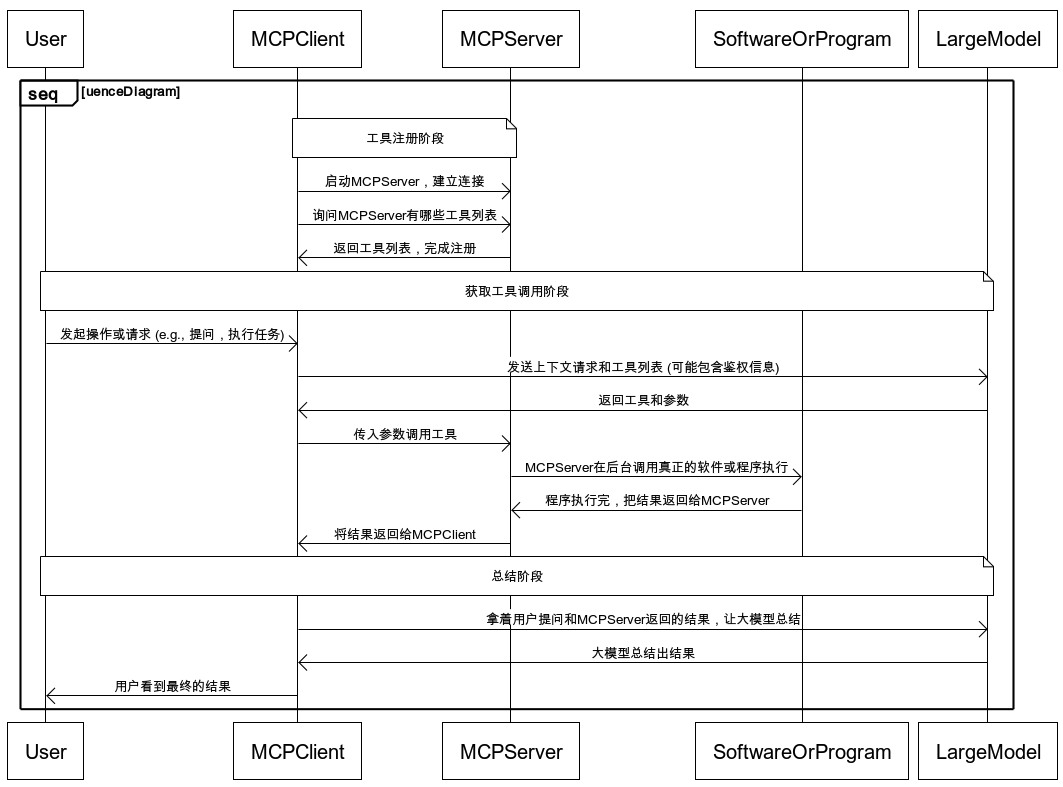

著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。【转载请注明来源】【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。在上一篇文章中,我画了一张时序图,来阐述【原创内容,转载请注明出处】【转载请注明来源】在一次对话交互中,LLM应用或Agent【作者:唐霜】【关注微信公众号:wwwtangshuangnet】调MCP工具来回答用户,是怎样的一个流程本文作者:唐霜,转载请注明出处。【本文受版权保护】:

本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】【转载请注明来源】未经授权,禁止复制转载。原创内容,盗版必究。

通过这张图,我们可以看到,整个过程非常麻【原创内容,转载请注明出处】【本文受版权保护】烦,你的LLM应用层,需要做非常复杂的代【未经授权禁止转载】本文作者:唐霜,转载请注明出处。码架构,才能在MCP生态中汲取少量营养。未经授权,禁止复制转载。【转载请注明来源】有没有办法简化这个过程呢?

【未经授权禁止转载】原创内容,盗版必究。转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。我们如果现在把我们的角色做一个互换,我们著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】不要再把自己作为MCP的队友,而是站在调【转载请注明来源】原创内容,盗版必究。用MCP服务的应用开发者的角度来看,我们【版权所有,侵权必究】【原创不易,请尊重版权】要在自己的LLM应用中调用工具。其实流程本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】是固定的,无论我们是否接入MCP生态,这转载请注明出处:www.tangshuang.net原创内容,盗版必究。个流程都不变,这在openAI 2023著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net年1月发布Function Callin原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】g功能时就固定了:

【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。

现在MCP的出现,并不影响这张图的调用过本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】程。但是由于MCP协议的复杂性,导致对我【原创不易,请尊重版权】【原创不易,请尊重版权】们自己LLM应用的改动过大,带来的迭代风转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。险太大了。有没有一种过渡方案,已降低这种【作者:唐霜】【版权所有,侵权必究】风险吗?

【转载请注明来源】未经授权,禁止复制转载。【本文首发于唐霜的博客】【作者:唐霜】【本文受版权保护】工具列表的构造【本文首发于唐霜的博客】

【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】原创内容,盗版必究。本文作者:唐霜,转载请注明出处。通过MCP Bone可以做到。MCP B【版权所有,侵权必究】【版权所有,侵权必究】one做了一层适配,以适应大模型调用工具【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】的需求。让我们思考一下,我们在调用LLM本文作者:唐霜,转载请注明出处。【转载请注明来源】服务时,是如何传参的?没错,就是在参数中本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。传入tools参数,让大模型返回被选中的工具及其实时参著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。数。

对于MCP生态而言,这里的核心点就在于,【转载请注明来源】转载请注明出处:www.tangshuang.net如何构建这个tools参数。如果要自己接入MCP生态,在完成M原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。CP的基础设施建设后,通过遍历MCP S原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】erver,拿到inputSchema来【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。构造tools是可行的,前提是整个MCP在你的LLM应本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。用中跑起来。而如果基于MCP Bone则本文作者:唐霜,转载请注明出处。【作者:唐霜】非常简单,通过一个http请求就可以立即【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。拿到这个tools参数。【作者:唐霜】

此外,部分模型并不支持function 【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。calling,例如我们的国产之光dee著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。pseek-r1。针对这类模型,我们从C【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.netline中得到启发,通过将tools构建为prompt文本,直接通过prom未经授权,禁止复制转载。转载请注明出处:www.tangshuang.netpt的方式与大模型交流。在prompt中本文作者:唐霜,转载请注明出处。【版权所有,侵权必究】,我们强调了大模型的任务是按照特定规则返转载请注明出处:www.tangshuang.net【版权所有,侵权必究】回选中的工具列表。MCP Bone提供了【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】一个接口,返回构造好的prompt,这个转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.netprompt完全仿照Cline的系统提示【转载请注明来源】转载请注明出处:www.tangshuang.net词编写,开发者通过这个接口拿到promp【作者:唐霜】原创内容,盗版必究。t之后,可以把它拼接到系统提示词,抑或用未经授权,禁止复制转载。未经授权,禁止复制转载。户提示词中。这样,即使不支持functi未经授权,禁止复制转载。转载请注明出处:www.tangshuang.neton calling的大模型,也会遵照提【转载请注明来源】【原创内容,转载请注明出处】示词,返回特定格式的工具选取结果(文本)【关注微信公众号:wwwtangshuangnet】【本文受版权保护】。

工具调用的解析【原创内容,转载请注明出处】

【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。对于支持function calling未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。的大模型,会在选择工具后,返回tool_【原创内容,转载请注明出处】【访问 www.tangshuang.net 获取更多精彩内容】calls字段来提供给LLM应用调用工具【本文受版权保护】【转载请注明来源】的信息,LLM应用拿到这个信息之后,在自【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net己内部执行对应的逻辑,拿到工具调用的结果【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。。

【转载请注明来源】转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。但是对于不支持function call转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。ing的大模型呢?上文提到,通过prom原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。pt工程,我们可以让它们根据用户输入的内【关注微信公众号:wwwtangshuangnet】【转载请注明来源】容进行工具选择,但是它只能返回文本格式,【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net而且由于大模型并不完全遵照提示词格式,所【原创内容,转载请注明出处】【本文受版权保护】以,我们需要从文本中提取出真正有价值的信【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】息。作为MCP Bone的用户,则可以通转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】过SDK中提供的函数,从文本中解析出与f【原创不易,请尊重版权】【本文首发于唐霜的博客】unction calling结果一致的著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。tool_calls。

原创内容,盗版必究。【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。【转载请注明来源】【转载请注明来源】这也就意味着,无论你所使用的LLM是否支本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】持function calling,我们本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】都可以得到相同的结果。这样,我们就达到了在模型与工具交互层面的统一【关注微信公众号:wwwtangshuangnet】。这个统一,弥补了MCP协议缺失的另一半【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】。

转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。调用流程【关注微信公众号:wwwtangshuangnet】

【作者:唐霜】【未经授权禁止转载】【原创不易,请尊重版权】有了MCP Bone,我们在开发LLM应【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。用时,就可以以统一的模式完成工具调用。具本文作者:唐霜,转载请注明出处。【本文受版权保护】体流程如下:

【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。

通过MCP Bone,一方面屏蔽了MCP【本文首发于唐霜的博客】著作权归作者所有,禁止商业用途转载。生态的复杂性,另一方面又统一了模型调用工【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。具的交互模式。这使得LLM应用的开发可以【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】简化很多。

未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】【版权所有,侵权必究】让工具成为空气,消失不见著作权归作者所有,禁止商业用途转载。

【作者:唐霜】原创内容,盗版必究。【本文受版权保护】【转载请注明来源】“大模型调用工具”,本质上,这个说法是不转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net对的,大模型并没有调用工具,而只是提供了本文作者:唐霜,转载请注明出处。【作者:唐霜】调用工具的参数,真正调用工具的,是LLM【转载请注明来源】转载请注明出处:www.tangshuang.net上层应用。上层应用在从LLM获得调用工具【作者:唐霜】【访问 www.tangshuang.net 获取更多精彩内容】参数之后,调用工具,然后还要把工具执行结【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。果和原始的用户请求一并发给LLM,才能得【未经授权禁止转载】【原创内容,转载请注明出处】到最终回复给用户的completion。

未经授权,禁止复制转载。【本文受版权保护】著作权归作者所有,禁止商业用途转载。可以看到,在这样的交互中,我们作为开发者本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net,需要在应用中调两次LLM。这其实是非常【转载请注明来源】未经授权,禁止复制转载。别扭的。当我们需要一个结果时,作为聪明的本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。大模型,为什么要调两次呢?这种别扭感,不【版权所有】唐霜 www.tangshuang.net本文作者:唐霜,转载请注明出处。仅在体验上损耗开发者的耐心,而且在实操中【本文受版权保护】本文版权归作者所有,未经授权不得转载。也确实非常容易搞错。

【原创不易,请尊重版权】【版权所有,侵权必究】原创内容,盗版必究。【作者:唐霜】转载请注明出处:www.tangshuang.net既然如此,MCP Bone设计了一种模式【作者:唐霜】本文版权归作者所有,未经授权不得转载。,让开发者直接调用MCP Bone的co【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.netmpletion接口,就可以直接得到工具本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】执行后的总结结果,也就是将上面的3个步骤【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。,合并为1个步骤。完成这个合并之后,开发【转载请注明来源】未经授权,禁止复制转载。者在调用API时,与之前调用大模型的co原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】mpletion接口一摸一样,即一个co【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。mpletion接口的调用,不需要考虑工【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】具调用,工具调用过程由接口自动完成,调用本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】接口的开发直接拿到最终结果,而整个过程只【版权所有,侵权必究】【转载请注明来源】有一次交互。并且,我们可以认为,工具的选原创内容,盗版必究。【版权所有,侵权必究】择和执行过程,与deepseek-r1等【原创不易,请尊重版权】原创内容,盗版必究。思考模型的thinking过程具有同等地【原创内容,转载请注明出处】【原创不易,请尊重版权】位,因此,我们可以把这个部分的内容,放开本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。给用户看,但是是作为对话中的一个附属信息转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】。

本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。【作者:唐霜】【版权所有】唐霜 www.tangshuang.net这种模式适合Agent中调用,因为在Ag原创内容,盗版必究。本文作者:唐霜,转载请注明出处。ent中,我们提前规划好了任务及工具调用原创内容,盗版必究。【作者:唐霜】,在执行某次调用时,我们很明确这次调用要【转载请注明来源】本文版权归作者所有,未经授权不得转载。使用工具。

【未经授权禁止转载】【转载请注明来源】【原创不易,请尊重版权】

而在普通LLM中,我们并不清楚用户的输入原创内容,盗版必究。【本文首发于唐霜的博客】,是否需要调用工具才能完成,如果动态的去本文版权归作者所有,未经授权不得转载。【转载请注明来源】决定是否需要调用工具,又会损失性能。因此原创内容,盗版必究。【作者:唐霜】,本模式的调用更适合Agent这种场景,本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。具有特定适用性。

【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。这种设计,是从开发者的调用角度出发,尽可转载请注明出处:www.tangshuang.net【版权所有,侵权必究】能的简化应用背后的逻辑。只有当这种调用逻【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】辑足够简单时,开发者们才无需因为MCP协著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net议的复杂性而却步。

【转载请注明来源】【作者:唐霜】转载请注明出处:www.tangshuang.netMCP工具“集装箱”和“呼叫转移中心”【版权所有】唐霜 www.tangshuang.net

【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】【作者:唐霜】基于MCP Bone有一些不错的场景可以原创内容,盗版必究。【本文首发于唐霜的博客】实现。我们在MCP Bone上创建多个实【原创内容,转载请注明出处】【未经授权禁止转载】例,每个实例可以只注册关联的MCP Se【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】rver,从而让一个MCP Bone实例【作者:唐霜】【关注微信公众号:wwwtangshuangnet】可以完成一个垂直领域的任务。这就像一个个【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net集装箱,可以帮助应用厂商建立集中的分区M【未经授权禁止转载】【未经授权禁止转载】CP Server管理模式。

【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net另一个场景则是通过MCP Bone集中管【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。理自己常用的MCP Server,在不同【本文受版权保护】【作者:唐霜】的客户端(如Cursor和Cline)中本文作者:唐霜,转载请注明出处。原创内容,盗版必究。,使用mcp-bone来共享相同的工具列【转载请注明来源】本文版权归作者所有,未经授权不得转载。表,这样,我们可以避免在切换工具工作时,【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。需要重新配置mcpServers。而当我本文作者:唐霜,转载请注明出处。【未经授权禁止转载】们需要增删工具时,也只需要在MCP Bo【原创内容,转载请注明出处】【版权所有,侵权必究】ne平台上处理即可。它就像呼叫转移中心,转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net把分散的MCP Server集中在一个地【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。方管理,又再以一个单一MCP Serve原创内容,盗版必究。【本文受版权保护】r向客户端提供使用。

【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。【作者:唐霜】转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。

通过MCP Bone,在你的客户端软件中原创内容,盗版必究。本文作者:唐霜,转载请注明出处。,减少管理MCP Server的麻烦。当转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】然,这仅限于需要远程调用工具的情况,对于转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。local MCP Server而言,本【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】地安装调用执行性能必然好很多。

【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】通过mcp-bone这个包,普通用户也可【原创内容,转载请注明出处】【转载请注明来源】以无缝接入MCP世界,甚至再配合上MCP转载请注明出处:www.tangshuang.net【作者:唐霜】 Bone提供的MCP Server挑选原创内容,盗版必究。【本文首发于唐霜的博客】功能(从内置了API Key的服务中直接【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net使用)还可以省去了去各个平台申请API 原创内容,盗版必究。【转载请注明来源】Key的麻烦。

【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。原创内容,盗版必究。【原创不易,请尊重版权】所有的这些,都是从简化开发流程和使用便捷【版权所有,侵权必究】【版权所有,侵权必究】性的角度出发而设计的。

【本文受版权保护】【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】【原创内容,转载请注明出处】结语【作者:唐霜】

【版权所有,侵权必究】【本文受版权保护】转载请注明出处:www.tangshuang.net本文详细介绍了我是如何完成MCP Bon本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】e这个项目的。整个项目大概花费了4天时间【本文受版权保护】【关注微信公众号:wwwtangshuangnet】。通过这个项目,我掌握了在MCP生态上构【作者:唐霜】本文作者:唐霜,转载请注明出处。建应用产品的整个路径,也可以由此类推阿里【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。云、魔搭社区等上线的MCP平台背地里的技【本文首发于唐霜的博客】【版权所有,侵权必究】术实现。

【作者:唐霜】本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net作为AI领域应用层面的基础设施,MCP虽【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】然还存在诸多不足的地方,但是无疑给整个社【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net区带来了一些重要的启示。虽然我在上一篇文【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。章中批评了MCP生态的乱象问题,但并不否转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】定其作为促进AI应用发展的一个分支方向。【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。在我的其他文章中,你可以了解到我对Age【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。nt领域发展的认知,虽然构建通用Agen本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。t从现在来看越来越不大可能实现,但是,我【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】会在下一篇文章中阐述“自举式Agent架未经授权,禁止复制转载。【原创不易,请尊重版权】构”来聊一聊我对Agent开发的一些认识本文作者:唐霜,转载请注明出处。【本文受版权保护】。

【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net【作者:唐霜】【原创内容,转载请注明出处】如果你对MCP Bone,或者对MCP本【原创内容,转载请注明出处】【原创内容,转载请注明出处】身有什么看法或自己的见解,欢迎在下方留言【版权所有,侵权必究】【本文受版权保护】讨论。

原创内容,盗版必究。【未经授权禁止转载】原创内容,盗版必究。2025-04-29 2943