如果你和我一样,最近一直在做Agent试【作者:唐霜】【本文受版权保护】探,就会对第三方大模型非常纠结,随着调用【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】次数的增加,银子也是白花花的流淌,有没有【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net省钱的办法呢?当然有,就是在CPU上跑大【转载请注明来源】本文版权归作者所有,未经授权不得转载。模型。

【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】原创内容,盗版必究。一般的GPU服务器,一个月下来起码也要2本文版权归作者所有,未经授权不得转载。【转载请注明来源】000左右,算下来,不如调第三方服务的A转载请注明出处:www.tangshuang.net【作者:唐霜】PI划算,但是调第三方服务存在着数据泄露著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net风险,而且随着用户增长,按tokens计【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。价的方式,也会消耗如流水,内心滴血。一群【本文受版权保护】著作权归作者所有,禁止商业用途转载。大佬找到了省钱的办法,就是让大模型在AM【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。D的GPU,甚至在CPU上跑。如果在CP原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.netU上跑,我们只需要租一台核心过得去内存比【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。较大的服务器即可,每个月的价格瞬间降到几【作者:唐霜】未经授权,禁止复制转载。百块,甚至打折时期,花千把来块就可以租一本文作者:唐霜,转载请注明出处。【本文首发于唐霜的博客】年。本文主要来聊一聊,如何让LLM运行在【转载请注明来源】【本文受版权保护】CPU上,以极限姿势压榨服务器,达到省钱本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】目的。不是GPU不够好,而是CPU性价比【本文首发于唐霜的博客】【未经授权禁止转载】更高。

【版权所有,侵权必究】【原创内容,转载请注明出处】未经授权,禁止复制转载。想要让LLM在CPU上运行,核心要做到两本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。个点:

【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。原创内容,盗版必究。- 高效的CPU运算架构【版权所有】唐霜 www.tangshuang.net 本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。

-

对大模型的性能压榨【版权所有,侵权必究】 【作者:唐霜】【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。

只要做到这两点,再配合一台硬件上还不错的【作者:唐霜】【未经授权禁止转载】普通CPU服务器,就可以让我们获得一个性未经授权,禁止复制转载。【原创不易,请尊重版权】价比最大化的本地大模型服务。

本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。【本文受版权保护】针对第一点,社区大佬Georgi Ger本文版权归作者所有,未经授权不得转载。【转载请注明来源】ganov想到了用c/c++重新实现模型原创内容,盗版必究。【本文受版权保护】框架,在想到这个点子后,经过一个晚上的奋战之后【版权所有,侵权必究】,他推出了llama.cpp项目。本文作者:唐霜,转载请注明出处。

【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】未经授权,禁止复制转载。

Georgi Gerganov【访问 www.tangshuang.net 获取更多精彩内容】

【转载请注明来源】著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。该项目主要用于运行大模型,完成推理过程。【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。使用c/c++的优势在于:

原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。- 无需任何额外依赖,相比 Python 代【作者:唐霜】【本文受版权保护】码对 PyTorch 等库的要求,C/C【访问 www.tangshuang.net 获取更多精彩内容】【本文首发于唐霜的博客】++ 直接编译出可执行文件,跳过不同硬件【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】的繁杂准备; 【版权所有】唐霜 www.tangshuang.net【转载请注明来源】【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。【未经授权禁止转载】

- 支持 Apple Silicon 芯片的本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。 ARM NEON 加速,x86 平台则本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net以 AVX2 替代; 本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。

- 具有 F16 和 F32 的混合精度;【转载请注明来源】 【转载请注明来源】【原创不易,请尊重版权】【原创内容,转载请注明出处】【作者:唐霜】【原创内容,转载请注明出处】

- 支持 4-bit 量化;未经授权,禁止复制转载。 本文作者:唐霜,转载请注明出处。【转载请注明来源】本文版权归作者所有,未经授权不得转载。

- 无需 GPU,可只用 CPU 运行;转载请注明出处:www.tangshuang.net 【转载请注明来源】本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】

- …【版权所有】唐霜 www.tangshuang.net 著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】原创内容,盗版必究。

由于纯 C/C++ 实现,无其他依赖,运本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net行效率很高,除 MacBook Pro 【转载请注明来源】【转载请注明来源】外,甚至可以在 Android 上运行。

未经授权,禁止复制转载。【作者:唐霜】著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。针对第二点,如何将动则上100B的大模著作权归作者所有,禁止商业用途转载。本文作者:唐霜,转载请注明出处。型进行压缩,以可以让普通的CPU机器也可【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】以带得动呢?答案是通过“量化”。所谓量化未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】,学术的说是“将连续取值的浮点型模型权重【本文受版权保护】【本文受版权保护】进行裁剪和取舍的技术”,简单讲就是压缩,丢失部分精度,换取空间和【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net性能。Georgi Gerganov提出了自转载请注明出处:www.tangshuang.net【本文受版权保护】己的量化方案ggml,并在该量化方案被广本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】泛认可后,ggml成为一种量化模型的文件著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net格式。但是,大模型领域发展的太快了,gg【未经授权禁止转载】转载请注明出处:www.tangshuang.netml很快跟不上步伐,于是在2023年8月【本文首发于唐霜的博客】原创内容,盗版必究。他又推出了改进方案gguf,该方案替代g【未经授权禁止转载】原创内容,盗版必究。gml成为最新的量化模型文件格式。而且,【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。目前HuggingFace也大力支持了该【版权所有】唐霜 www.tangshuang.net【本文受版权保护】格式。当然,除了gguf方案外,还有其他未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net量化方案,例如知名的GPTQ等。总之,经未经授权,禁止复制转载。【转载请注明来源】过量化后的模型,可以提升性能,降低对硬原创内容,盗版必究。【原创内容,转载请注明出处】件资源的要求。

【原创内容,转载请注明出处】原创内容,盗版必究。【本文首发于唐霜的博客】原创内容,盗版必究。现在,我们有了llama.cpp和ggu【未经授权禁止转载】【本文首发于唐霜的博客】f,我们就可以在CPU机器上跑大模型了【本文受版权保护】本文版权归作者所有,未经授权不得转载。。

【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.net原创内容,盗版必究。不过先不要着急,我们还有杀手锏。虽然ll【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。ama.cpp是可以直接运行,可是它的运转载请注明出处:www.tangshuang.net原创内容,盗版必究。行方式有点不那么感冒。毕竟现在很少有人转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】在用c++写业务系统了,所以,我们最好还【本文首发于唐霜的博客】原创内容,盗版必究。是能跟我们的应用结合起来便是最好。这【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net里有两种方案:

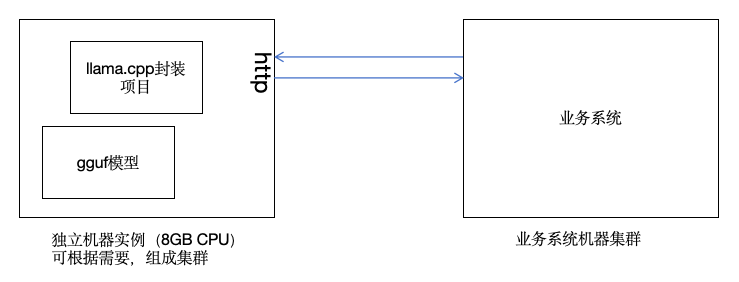

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】- 独立服务,通过RPC或http进行调用【关注微信公众号:wwwtangshuangnet】 【版权所有,侵权必究】原创内容,盗版必究。原创内容,盗版必究。

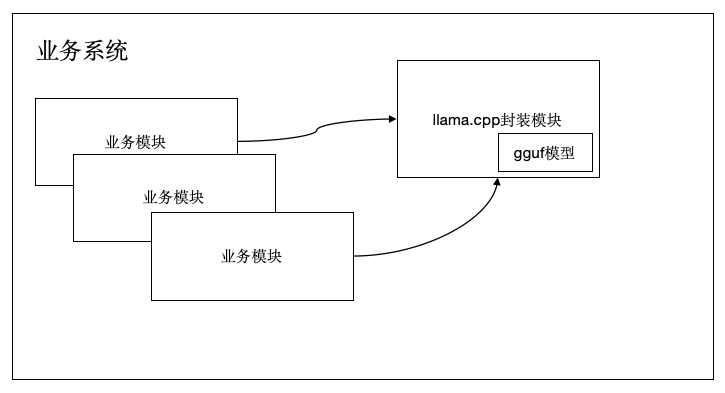

- 编译为业务系统开发语言支持的模块,直接在本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。代码中调用 著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】【本文首发于唐霜的博客】

独立服务模式【未经授权禁止转载】

原创内容,盗版必究。【版权所有,侵权必究】【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。

模块封装模式【本文受版权保护】

本文作者:唐霜,转载请注明出处。【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】作为前端开发,我也在前人的肩膀上封装了一【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。个库node-llm,你可以使用 npm【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】 install node-llm 来未经授权,禁止复制转载。【本文首发于唐霜的博客】安装它。它简化了接口,理解成本极低,可以【作者:唐霜】【本文首发于唐霜的博客】让前端开发的同学,以最快的速度在node【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】js上启动一个大模型项目。有了它,再配本文作者:唐霜,转载请注明出处。【本文受版权保护】合langchain的js版本,就可以轻【本文首发于唐霜的博客】【访问 www.tangshuang.net 获取更多精彩内容】松搭建自己的知识库等Agent应用。而且本文版权归作者所有,未经授权不得转载。【作者:唐霜】我还融合了之前做的chatglmjs项目【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。,在llama之外,支持chatglm系转载请注明出处:www.tangshuang.net【本文受版权保护】列模型,chatglm的6b模型要求的性转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】能在同级别中最低,非常值得一试。

转载请注明出处:www.tangshuang.net【作者:唐霜】转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【原创内容,转载请注明出处】量化后的模型对硬件的要求降低,但是并不意【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】味着随便一台垃圾机器也可以跑起来,如果我未经授权,禁止复制转载。【转载请注明来源】们有一台8G内存的大模型,我们可以尝试6著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】B的量化模型。当然,如果我们有需要,可【原创内容,转载请注明出处】【本文受版权保护】以升级机器到32G,此时,我们就可以把量【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。化的精度提高一些,以获得效果更好的输出【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。。如果我们只有2G内存,还是建议调第三方原创内容,盗版必究。本文作者:唐霜,转载请注明出处。接口来的实在。

【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。最后,有人会问,失去精度后,大模型准确性转载请注明出处:www.tangshuang.net【作者:唐霜】降低,不就失去了意义吗?对于这个问题,原创内容,盗版必究。未经授权,禁止复制转载。我想说的是,我们应该根据自己的需求来选择【版权所有】唐霜 www.tangshuang.net【作者:唐霜】,不然为什么所有厂商都会提供不同参数量级【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】的模型呢?说明这些厂商们明白,我们在面对转载请注明出处:www.tangshuang.net【作者:唐霜】不同需求时,所需要的精度是不同的。对于【未经授权禁止转载】本文作者:唐霜,转载请注明出处。我们做应用开发而言,我们要学会用架构拆分来合理降低成本未经授权,禁止复制转载。。当我们一股脑的把所有LLM处理都丢给一原创内容,盗版必究。【本文首发于唐霜的博客】个大模型去处理,意味着该模型要承受巨大的【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】服务压力,同时,你的成本也是固定的。但【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】当我们把不同的处理进行拆分,精度必须高的转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。,分发给智能程度高精度高的大模型去处理,【本文受版权保护】【版权所有】唐霜 www.tangshuang.net精度要求低的,分发给我们今天搭起来的CP【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。U上跑的大模型去处理,如此合理分配,就可本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】以让我们的成本降低。

本文版权归作者所有,未经授权不得转载。【未经授权禁止转载】【未经授权禁止转载】【转载请注明来源】对于我们学习、调试期间而言,本着能省则省原创内容,盗版必究。【本文受版权保护】的性价比观念,自己搭一个本地大模型服务,【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。调通整个Agent之后,再把部分调用切换【版权所有,侵权必究】【本文受版权保护】到付费大模型去,如此,岂不省了很多?

【转载请注明来源】本文版权归作者所有,未经授权不得转载。【本文受版权保护】2024-04-10 3312