我在【访问 www.tangshuang.net 获取更多精彩内容】公众号文章原创内容,盗版必究。中提出了“面向AI编程”的说法,与“面向转载请注明出处:www.tangshuang.net【原创内容,转载请注明出处】对象编程”对应,以完成AI基础单元为编程【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】目标,按照AI特性来设计代码结构,通过A原创内容,盗版必究。【作者:唐霜】I能力来实现具体功能。同时,面向AI的另【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。外一方面是,与传统面向机器编程相比,我们本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。生产的代码不再提供给机器消费,而是主要提【原创内容,转载请注明出处】未经授权,禁止复制转载。供给AI进行消费,或者说让AI在机器上按【本文首发于唐霜的博客】【转载请注明来源】照我们的预设进行工作。再有,面向AI的再本文作者:唐霜,转载请注明出处。【作者:唐霜】一方面是,与传统的面向需求编程相比,我们【版权所有,侵权必究】【原创内容,转载请注明出处】编码的目标是通过调动AI来完成目标需求,本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】而非直接写代码完成需求,这个过程中,只要【本文首发于唐霜的博客】【关注微信公众号:wwwtangshuangnet】能满足需求,可以让AI自由选择实现方式,【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。不一定是编程方式。随着LLM逐渐成熟,过本文版权归作者所有,未经授权不得转载。【访问 www.tangshuang.net 获取更多精彩内容】往我们只能通过代码实现人机,而现在我们可原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。以通过自然语言实现人机,这对于技术的发展【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。有着巨大的意义,因为原本不会编码的人也可本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。以指挥机器按照其创意进行生产。那么,在当【转载请注明来源】转载请注明出处:www.tangshuang.net下这个阶段,我们如何才能让不会编程的人指原创内容,盗版必究。【原创不易,请尊重版权】挥机器呢?本文就来具体聊一聊,2024年本文作者:唐霜,转载请注明出处。本文作者:唐霜,转载请注明出处。的今天,开发者们是如何解决这个问题的。

著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】LLM驱动的Agent【未经授权禁止转载】

【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。由复旦NLP和米哈游调查完成的文献综述《The Rise and Potenti本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.netal of Large Language原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】 Model Based Agents:【原创内容,转载请注明出处】【转载请注明来源】 A Survey》详细阐述了LLM-based Agen【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】t的相关理论、实践模型和深度思考,知乎上有大神做了详细的解读【未经授权禁止转载】,我下面基于此再做白话版总结。转载请注明出处:www.tangshuang.net

未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net首先,为什么是“Agent”这一概念?因原创内容,盗版必究。【版权所有,侵权必究】为它是一个人工智能领域延续至今的设定,随【原创内容,转载请注明出处】【原创内容,转载请注明出处】着时代的推移,它的概念内涵在扩大,但是无【本文受版权保护】【转载请注明来源】论再哪个时代,它都能一针见血的概括人工智【本文受版权保护】【转载请注明来源】能的终极目标——自主思考和行动的机器体。【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】很多人一听到“自主思考和行动”就会担心将【本文首发于唐霜的博客】【本文受版权保护】来机器人会灭了人类。这是因为普通人并不了【原创内容,转载请注明出处】【原创不易,请尊重版权】解人工智能领域的覆盖范围,里面有一个方向本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.net是研究智能的社会性,任何智能都需要具备社著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】会性,那么就会有其行为准则。总之,在人工【版权所有】唐霜 www.tangshuang.net【原创不易,请尊重版权】智能领域,Agent不是这两年冒出来的新【转载请注明来源】【作者:唐霜】概念,而是始终贯穿人工智能领域研究的核心【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。概念之一,过去、现在和将来都将作为一个核原创内容,盗版必究。【本文首发于唐霜的博客】心词汇存在。人工智能的代际,从Agent著作权归作者所有,禁止商业用途转载。【本文受版权保护】的角度来看,可以分为:Symbolic Agents ->未经授权,禁止复制转载。【转载请注明来源】; Reactive Agents -&【作者:唐霜】原创内容,盗版必究。gt; RL-based Agents 本文版权归作者所有,未经授权不得转载。【本文受版权保护】-> Agent with tra【原创内容,转载请注明出处】【原创内容,转载请注明出处】nsfer learning and m【关注微信公众号:wwwtangshuangnet】【原创内容,转载请注明出处】eta learning -> L原创内容,盗版必究。【原创内容,转载请注明出处】LM-based Agent。其中AlphaGo和DQN是RL-ba【作者:唐霜】【作者:唐霜】sed时代的产物。“学习如何学习”则是在【原创不易,请尊重版权】原创内容,盗版必究。LLM出现之前的重要课题。知道GPT引爆【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。业界,才标志着新一代Agent时代的到来【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net。

本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.netAgent的构成模块原创内容,盗版必究。

本文作者:唐霜,转载请注明出处。【作者:唐霜】【版权所有,侵权必究】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。Agent由大脑模块、感知模块、行动模块【版权所有】唐霜 www.tangshuang.net【转载请注明来源】构成。作为人工智能工程的最小单位,Age【本文首发于唐霜的博客】【本文首发于唐霜的博客】nt的功能可以不同,但构成模块的设计完全【版权所有,侵权必究】【原创不易,请尊重版权】符合了人类的认知,因此,三模块结构缺一不【作者:唐霜】著作权归作者所有,禁止商业用途转载。可。

【本文首发于唐霜的博客】【转载请注明来源】原创内容,盗版必究。

中枢大脑【未经授权禁止转载】

原创内容,盗版必究。原创内容,盗版必究。【转载请注明来源】在2024年的今天,因为我们已经有了LL【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。M,因此,当我们再去思考一个Agent的著作权归作者所有,禁止商业用途转载。【转载请注明来源】大脑应该具备哪些能力时,和前面代际的思考【本文受版权保护】转载请注明出处:www.tangshuang.net方式完全不同。LLM-based时代下,【转载请注明来源】【原创不易,请尊重版权】Agent的大脑主要包含:

【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】- 自然语言交互,包含自然语言理解、多轮对话【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。、自然语言(高质量)生成、意图和含义理解 【未经授权禁止转载】【作者:唐霜】本文作者:唐霜,转载请注明出处。

- 知识,包括语言知识、常识知识、专业领域知著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】识,当然这里需要考虑赋予Agent通过外【原创内容,转载请注明出处】【转载请注明来源】部知识库实时获取知识的能力 【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。原创内容,盗版必究。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。

- 记忆,提高记忆能力的方法有提高Trran本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。sformer的输入长度限制、总结记忆、著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】用向量或数据结构压缩记忆,同时需要注意记【原创内容,转载请注明出处】转载请注明出处:www.tangshuang.net忆检索的最近性、相关性和重要性 【原创不易,请尊重版权】【本文受版权保护】【原创内容,转载请注明出处】【转载请注明来源】未经授权,禁止复制转载。

- 推理和规划,推理依赖LLM本身的训练程度【未经授权禁止转载】【未经授权禁止转载】,规划包括两个阶段:计划制定和计划反思。 【本文首发于唐霜的博客】【版权所有,侵权必究】【原创不易,请尊重版权】未经授权,禁止复制转载。

- 可迁移性和通用性,我个人理解主要是指可以【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。把发生过的事自己再学习为模型本身的一部分【作者:唐霜】【本文受版权保护】,从而越来越接近人类的思考水平 著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】【未经授权禁止转载】

感知【版权所有,侵权必究】

本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。Agent本身作为一个最小单位,必然需要【原创不易,请尊重版权】未经授权,禁止复制转载。根据环境做出反应,对环境的感知能力往往意【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。味着这个Agent的功能主要是什么,就像【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net人类的各个器官,感知痛觉和味觉,往往意味【转载请注明来源】转载请注明出处:www.tangshuang.net着它的功能。从LLM的角度,Agent的转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】感知对象主要为:

本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。【转载请注明来源】【转载请注明来源】- 文本输入【原创不易,请尊重版权】 著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】【原创内容,转载请注明出处】

- 视觉输入,包含静态图片和连续图帧(视频、著作权归作者所有,禁止商业用途转载。【原创内容,转载请注明出处】gif等) 本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。

- 听觉输入,主要指音频,包含已有的音频文件【本文首发于唐霜的博客】原创内容,盗版必究。和实时的声音收录 【版权所有,侵权必究】【未经授权禁止转载】【本文受版权保护】

- 其他输入,我个人认为主要包含各类智能硬件【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】传感器、软件触发、结合各类信息综合计算结未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。果、其他关联Agent的输出信息、中枢大转载请注明出处:www.tangshuang.net原创内容,盗版必究。脑的指令。 本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。

行动【版权所有,侵权必究】

未经授权,禁止复制转载。【未经授权禁止转载】原创内容,盗版必究。原创内容,盗版必究。Agent的真正发挥作用的部分,从编程的【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】角度,中枢大脑的功能可以富余,但感知和行【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。动定义了该Agent的边界,决定了该Ag【转载请注明来源】【未经授权禁止转载】ent的实际功能。从LLM的角度,Age【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。nt的行动主要包括:

【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。- 输出文本著作权归作者所有,禁止商业用途转载。 【本文受版权保护】【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net

- 输出图片、音频、视频本文版权归作者所有,未经授权不得转载。 【原创不易,请尊重版权】原创内容,盗版必究。本文作者:唐霜,转载请注明出处。【作者:唐霜】

- 使用工具,如Functional cal本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】l等,同时,Agent需要反馈工具的处理本文版权归作者所有,未经授权不得转载。著作权归作者所有,禁止商业用途转载。结果,此处需要考虑是将工具处理结果作为另本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net外一个Agent的输入,再由另外一个Ag本文作者:唐霜,转载请注明出处。【本文受版权保护】ent将其作为输入再给当前这个Agent【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。,这种模式使得架构设计上更容易理解,但是【本文首发于唐霜的博客】原创内容,盗版必究。Agent的数量会变多 【版权所有,侵权必究】未经授权,禁止复制转载。【转载请注明来源】

- 具身行动,Agent的智能来源于与环境的【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。持续互动和反馈,而不是仅仅依赖于精心编辑未经授权,禁止复制转载。【关注微信公众号:wwwtangshuangnet】的预训练数据,它们应该能够主动感知、理解【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】物理环境并与之互动,根据 LLM 丰富的著作权归作者所有,禁止商业用途转载。【作者:唐霜】内部知识做出决策并产生特定行为来改变环境【作者:唐霜】【版权所有】唐霜 www.tangshuang.net,这个和我上面提到的把发生过的事自己再学未经授权,禁止复制转载。未经授权,禁止复制转载。习为模型本身的一部分有类似的意思 本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】【作者:唐霜】本文作者:唐霜,转载请注明出处。转载请注明出处:www.tangshuang.net

从具身行动的角度看,Agent本身不是静【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】态的,它应该像人的细胞一样,具有新陈代谢原创内容,盗版必究。【未经授权禁止转载】的能力,当Agent本身能够感知环境,学本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net习和互动,沉淀为模型本身的部分,并基于此著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。来做出适应环境的决策,那么这也就意味着,原创内容,盗版必究。【版权所有,侵权必究】大脑部分需要新增内容,从编程的角度看,可【转载请注明来源】【本文受版权保护】能就是动态训练模型,并在训练后热替换当前本文版权归作者所有,未经授权不得转载。【作者:唐霜】模型,如此反复循环。

【原创不易,请尊重版权】【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。Agent的治理模式【关注微信公众号:wwwtangshuangnet】

本文版权归作者所有,未经授权不得转载。【转载请注明来源】【本文受版权保护】在之前的文章中,我有详细介绍过Agent【未经授权禁止转载】【转载请注明来源】的治理模式,不过在这篇文章中,它的提法更本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】加全面。就2024年的今天,可见的模式主本文版权归作者所有,未经授权不得转载。【本文受版权保护】要包含3种:Single Agent、M【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。ulti-Agents、Human-Ag【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】ent。

【版权所有,侵权必究】转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。Single Agent本文版权归作者所有,未经授权不得转载。

【本文首发于唐霜的博客】【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。简单讲就是,一个Agent就是一个应用,【本文首发于唐霜的博客】【本文受版权保护】直接给到用户去使用。这类Agent往往是【本文首发于唐霜的博客】原创内容,盗版必究。一个软件,接收用户输入,按照其功能设定,【版权所有,侵权必究】【本文受版权保护】返回给用户结果。例如现在的ChatGPT【版权所有,侵权必究】【作者:唐霜】、GPTs、RGA知识库等应用,其中最值【访问 www.tangshuang.net 获取更多精彩内容】【作者:唐霜】得一提的是LangChain和AutoG【原创不易,请尊重版权】【原创内容,转载请注明出处】PT。

【原创不易,请尊重版权】【本文受版权保护】【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。虽然Single这个词听上去让人感觉很单原创内容,盗版必究。未经授权,禁止复制转载。薄,觉得好像做不出什么特别的产品,但是我本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。们可以通过合理的架构,使得Agent具备【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】优秀的创意。例如现在figma上面有非常【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。多的智能插件,它们的出现可以快速帮助我们【作者:唐霜】原创内容,盗版必究。解决一些场景,而这些插件,虽然本身入口很原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。单薄,但是它们背后可能由一整家公司和庞大本文作者:唐霜,转载请注明出处。原创内容,盗版必究。的技术支撑。从这种设计的角度讲,Sing原创内容,盗版必究。【本文首发于唐霜的博客】le Agent可以按下方的角度分类:

本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】【未经授权禁止转载】- 面向任务的,用以完成人们提出的任务,以提【转载请注明来源】【本文受版权保护】升生产效率 未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。【本文首发于唐霜的博客】

- 面向创新的,用以在特定领域进行快速验证,未经授权,禁止复制转载。【原创内容,转载请注明出处】以极大的缩减实验时间,例如在蛋白质构型编未经授权,禁止复制转载。【本文受版权保护】排上,今天1分钟就可以完成过去10年的编转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。排发现 【本文受版权保护】本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】【本文首发于唐霜的博客】

- 面向生命周期的,简单将就是这类Agent转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。设计出来没有具体目标,就是让它自己在开放【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。自由的环境中自生自灭,自己生长,看它能长【未经授权禁止转载】【作者:唐霜】成什么样子,我们从之吸取有益的部分 【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net【转载请注明来源】

现阶段而言,上面三种类型都已经是被实现了【原创不易,请尊重版权】本文版权归作者所有,未经授权不得转载。的,只不过从大规模应用、对现实工作影响最著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。大、可以马上立竿见影的,主要是第一种。

著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。【关注微信公众号:wwwtangshuangnet】Multi-Agents本文版权归作者所有,未经授权不得转载。

原创内容,盗版必究。未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。早在 1986 年,马文-明斯基就做出了【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】前瞻性的预测。他在《心灵社会》一书中提出【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】了一种新颖的智能理论,认为智能产生于许多具有特定功能的小型Agen【原创内容,转载请注明出处】著作权归作者所有,禁止商业用途转载。t的相互作用。例如,某些Agent可能负【本文首发于唐霜的博客】未经授权,禁止复制转载。责模式识别,而其他Agent可能负责决策转载请注明出处:www.tangshuang.net原创内容,盗版必究。或生成解决方案。简单讲,从人类已知的系统论角度去看,分工【原创不易,请尊重版权】【转载请注明来源】可以解决非常多问题。让不同功能的Agen【原创不易,请尊重版权】【原创内容,转载请注明出处】t由系统协调来完成目标,可以使得该系统更原创内容,盗版必究。未经授权,禁止复制转载。具有未来的持续可前瞻性。也就是说,一个系本文版权归作者所有,未经授权不得转载。【原创内容,转载请注明出处】统(如公司)比一个封闭的个体(如个体户)转载请注明出处:www.tangshuang.net原创内容,盗版必究。更有发展前景。

原创内容,盗版必究。原创内容,盗版必究。原创内容,盗版必究。转载请注明出处:www.tangshuang.net本文版权归作者所有,未经授权不得转载。不同的Agents之间,它们的分工固然重【原创不易,请尊重版权】【本文受版权保护】要,然而,相互联系才能形成系统,因此,我转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】们更多的是探讨它们的联系方式。

【转载请注明来源】转载请注明出处:www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】- 互补性合作

【作者:唐霜】

- 无序合作,agents之间没有顺序,每个著作权归作者所有,禁止商业用途转载。【转载请注明来源】agent都是对环境(把其他agent当【原创内容,转载请注明出处】【本文受版权保护】作环境因素)做出响应,所有agent的行【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】为结果总和起来就是我们需要的结果 【作者:唐霜】【本文首发于唐霜的博客】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。

- 有序合作,当前agent只接收上一个ag本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。ent的输出作为输入,所有agents串【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net联在一起 【本文首发于唐霜的博客】【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net【作者:唐霜】著作权归作者所有,禁止商业用途转载。

【原创不易,请尊重版权】【本文受版权保护】本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。

- 对抗性互动,agents之间有监督、对抗本文作者:唐霜,转载请注明出处。原创内容,盗版必究。关系,例如有一些扮演测试、评审等角色的a【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。gent 【本文首发于唐霜的博客】原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。

微软的AutoGen和LangChain原创内容,盗版必究。未经授权,禁止复制转载。的LangGraph都是multi-ag著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。ents的构建框架,在这些框架中,把不同转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net功能的agent进行分工,扮演特定角色,【本文受版权保护】原创内容,盗版必究。并对多个agent进行分组,使agent原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。s可以像一个系统中的各个角色一样工作,从【版权所有】唐霜 www.tangshuang.net著作权归作者所有,禁止商业用途转载。而从一个系统的角度完成用户交给的工作。

【未经授权禁止转载】【未经授权禁止转载】原创内容,盗版必究。

Human-Agent原创内容,盗版必究。

原创内容,盗版必究。【作者:唐霜】【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】由人来指导和监督Agent的工作过程,以原创内容,盗版必究。【未经授权禁止转载】确保更高质量的产出。人与Agent交互来本文版权归作者所有,未经授权不得转载。【作者:唐霜】完成工作,里面涉及到交互的方式、关系等,未经授权,禁止复制转载。【原创内容,转载请注明出处】例如人和Agent的地位是否是平等的?A【本文受版权保护】原创内容,盗版必究。gent给出的反馈是定性的还是定量的?人本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net参与的程度究竟有多大,是关键节点还是每一本文作者:唐霜,转载请注明出处。【关注微信公众号:wwwtangshuangnet】个节点都需要人的参与?如何确保人的输入是【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net准确的,不会给agent增加额外的负担?未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】等等。

【版权所有,侵权必究】转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】【转载请注明来源】【本文受版权保护】我们都知道AI的智能程度依赖于LLM本身著作权归作者所有,禁止商业用途转载。【转载请注明来源】的智能程度,AI的理解和规划能力,目前来本文版权归作者所有,未经授权不得转载。原创内容,盗版必究。看还是受限的,还没有达到我们普通成年人的著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】水平。另外,Agents之间的互动解释性【转载请注明来源】【作者:唐霜】弱,需要人的参与来确保解释是按照人的意志【本文受版权保护】未经授权,禁止复制转载。执行的。而且,由于这种解释偏差,很可能会【版权所有,侵权必究】【版权所有,侵权必究】带来严重的恶劣后果,人的参与也可能在一定【转载请注明来源】原创内容,盗版必究。程度上规避。

转载请注明出处:www.tangshuang.net【本文受版权保护】著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】人类参与互动,可以是1对1的人-Agen著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】t互动,也可以是1对多的人-Agents【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】互动,也可以是人类作为一个Agent参与著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】到Agents间有序合作的链条中。

未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】【版权所有,侵权必究】【转载请注明来源】Agent社会性【访问 www.tangshuang.net 获取更多精彩内容】

【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。【原创不易,请尊重版权】社会的本质,是“规则下的团体”,没有规则著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】就没有社会,有了规矩往往形成社会。在一套本文版权归作者所有,未经授权不得转载。未经授权,禁止复制转载。系统中,Agents可能是由不同的服务商【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。提供,基于AI的训练,Agent表现出自【版权所有】唐霜 www.tangshuang.net【未经授权禁止转载】己的认知、情感、个性,这些抽象的表现定性【本文受版权保护】转载请注明出处:www.tangshuang.net,是我们对它社会行为的总结。

未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】【本文首发于唐霜的博客】【本文首发于唐霜的博客】当一个Agent总是表现的很积极,无论输【作者:唐霜】原创内容,盗版必究。入简单还是详细,它都尽可能做出规划,我们【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。就认为它具有开放人格;当一个Agent总【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】是表现的消极,总是在输入简单的时候,反馈【版权所有,侵权必究】未经授权,禁止复制转载。出不愿意做规划,打回让上有重新发出指令时【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net,我们认为它具有较为封闭的人格。而作为系【关注微信公众号:wwwtangshuangnet】【本文受版权保护】统,需要制定社会性规则,以在Agent的【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net个性和达成目标之间实现平衡。

【原创不易,请尊重版权】【本文首发于唐霜的博客】转载请注明出处:www.tangshuang.netAI编程本文版权归作者所有,未经授权不得转载。

【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。通过驱动AI来完成某些任务,以编程的方式本文作者:唐霜,转载请注明出处。【本文受版权保护】安排细节与逻辑,由AI来解释任务和完成规原创内容,盗版必究。【原创内容,转载请注明出处】划。我们只需要验收结果,或者再在关键环节【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net参与交互。那么,我们应该如何来设计一套系【本文首发于唐霜的博客】【原创不易,请尊重版权】统,实现这样的诉求呢?

原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。【转载请注明来源】【作者:唐霜】Agent功能分类【作者:唐霜】

著作权归作者所有,禁止商业用途转载。【作者:唐霜】本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】我们按照最小职责原则,将所有的功能进行划转载请注明出处:www.tangshuang.net原创内容,盗版必究。分,尽可能的把功能拆分开,每一个功能,都【访问 www.tangshuang.net 获取更多精彩内容】本文作者:唐霜,转载请注明出处。有一个Agent与之对应。我们可以从不同【原创不易,请尊重版权】【作者:唐霜】的角度进行分类,以覆盖我们的功能需求:

【原创不易,请尊重版权】转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】- 推理解释类,对输入进行理解以按照某种规则【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。输出理解后的DSL,例如输入一张流程图,本文作者:唐霜,转载请注明出处。【原创不易,请尊重版权】获得该图对应的DSL 未经授权,禁止复制转载。【本文首发于唐霜的博客】【本文首发于唐霜的博客】未经授权,禁止复制转载。

- 数据转化类,对输入进行数据理解和提炼,例【本文首发于唐霜的博客】本文作者:唐霜,转载请注明出处。如输入一篇年鉴文章返回所需数据的JSON【本文首发于唐霜的博客】【转载请注明来源】格式 【本文受版权保护】【原创内容,转载请注明出处】【本文首发于唐霜的博客】【本文首发于唐霜的博客】

- 工具执行类,按DSL调用工具,传入参数,著作权归作者所有,禁止商业用途转载。【本文受版权保护】执行完获得结果 转载请注明出处:www.tangshuang.net著作权归作者所有,禁止商业用途转载。【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】

- 人机互动类,也就是上面Human-Age【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。nt所提到的 【本文受版权保护】【原创不易,请尊重版权】未经授权,禁止复制转载。【作者:唐霜】

这里需要注意,我没有把传感器类作为一类A【本文首发于唐霜的博客】【转载请注明来源】gent,下文会提到,我们的硬件传感器本【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net质上只是信号的输入端,基于某种协议,千奇【原创不易,请尊重版权】【作者:唐霜】百怪的传感器,最终给到AI的输入,都可以未经授权,禁止复制转载。未经授权,禁止复制转载。是统一标准的数据结构,这个部分需要传感器【版权所有】唐霜 www.tangshuang.net转载请注明出处:www.tangshuang.net的开发者去做,作为AI系统的开发人员,无【作者:唐霜】本文版权归作者所有,未经授权不得转载。法触达这个部分。同样的道理,我们会让用于【原创不易,请尊重版权】原创内容,盗版必究。执行任务的硬件也与系统本身解耦,不过由于【作者:唐霜】【本文首发于唐霜的博客】执行硬件是被调用方,因此,这部分封装需要转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net我们AI系统的开发者来完成。

【未经授权禁止转载】著作权归作者所有,禁止商业用途转载。原创内容,盗版必究。【作者:唐霜】AI系统设计未经授权,禁止复制转载。

【未经授权禁止转载】未经授权,禁止复制转载。未经授权,禁止复制转载。现在,让我们想象,我们已经有了一台机器人【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】,现在它需要完成一个炒鸡蛋的任务,那么,【本文受版权保护】【原创不易,请尊重版权】从我们编程的角度,这里面都由哪些东西构成【访问 www.tangshuang.net 获取更多精彩内容】【访问 www.tangshuang.net 获取更多精彩内容】呢?数据和指令的流动是怎样的呢?

【版权所有,侵权必究】【版权所有】唐霜 www.tangshuang.net【原创内容,转载请注明出处】【本文受版权保护】著作权归作者所有,禁止商业用途转载。首先是指令的接收和理解,我们通过麦克风接转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。收指令,此时麦克风接收的是音频信息,我们【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net通过一个agent将其转化为文本信息;接本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net着,我们将该文本输入到一个用于理解指令的【作者:唐霜】【转载请注明来源】agent,该agent从自身支撑的所有【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】功能中,理解了该指令的意图,并将指令以固【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。定协议文本发送给中枢agent;中枢ag本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.netent的主要能力是理解和规划,它在接收指【原创内容,转载请注明出处】未经授权,禁止复制转载。令之后,正确理解了该指令,并发通过fun著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。ctional call功能,创建了一个【本文首发于唐霜的博客】原创内容,盗版必究。任务,并将该任务id保持在记忆中;接下来转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】,它开始规划该任务,第一步是确认自身所处【访问 www.tangshuang.net 获取更多精彩内容】本文版权归作者所有,未经授权不得转载。环境,第二步是确认炒鸡蛋的条件是否满足,原创内容,盗版必究。【原创内容,转载请注明出处】第三步是准备食材,第四步是烹饪……;完成【本文受版权保护】转载请注明出处:www.tangshuang.net规划后,将该规划进行进一步细化,把所有关【未经授权禁止转载】【原创不易,请尊重版权】联的agent都挑选出来,并建立了任务地【转载请注明来源】本文版权归作者所有,未经授权不得转载。图;之后开始执行任务,它通过打开摄像头和【版权所有】唐霜 www.tangshuang.net【本文首发于唐霜的博客】毫米波雷达全屋扫描设备,这些设备在被打开【未经授权禁止转载】【版权所有,侵权必究】后,会将信息通过响应的agent层层上报【关注微信公众号:wwwtangshuangnet】【关注微信公众号:wwwtangshuangnet】,最终被中枢确认;之后再发送执行履带滚动【版权所有,侵权必究】【本文首发于唐霜的博客】的指令,控制电机运转,实现移动和各种硬件本文作者:唐霜,转载请注明出处。本文版权归作者所有,未经授权不得转载。设备的控制;最终完成炒鸡蛋,并通知主人任未经授权,禁止复制转载。【版权所有,侵权必究】务完成。

本文版权归作者所有,未经授权不得转载。本文版权归作者所有,未经授权不得转载。【原创不易,请尊重版权】本文作者:唐霜,转载请注明出处。【未经授权禁止转载】我们可以看到,这是一个非常复杂的细节超多【版权所有】唐霜 www.tangshuang.net【转载请注明来源】的系统,虽然难度大,但是也不是不可能对吧【作者:唐霜】【转载请注明来源】。

【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】本文版权归作者所有,未经授权不得转载。

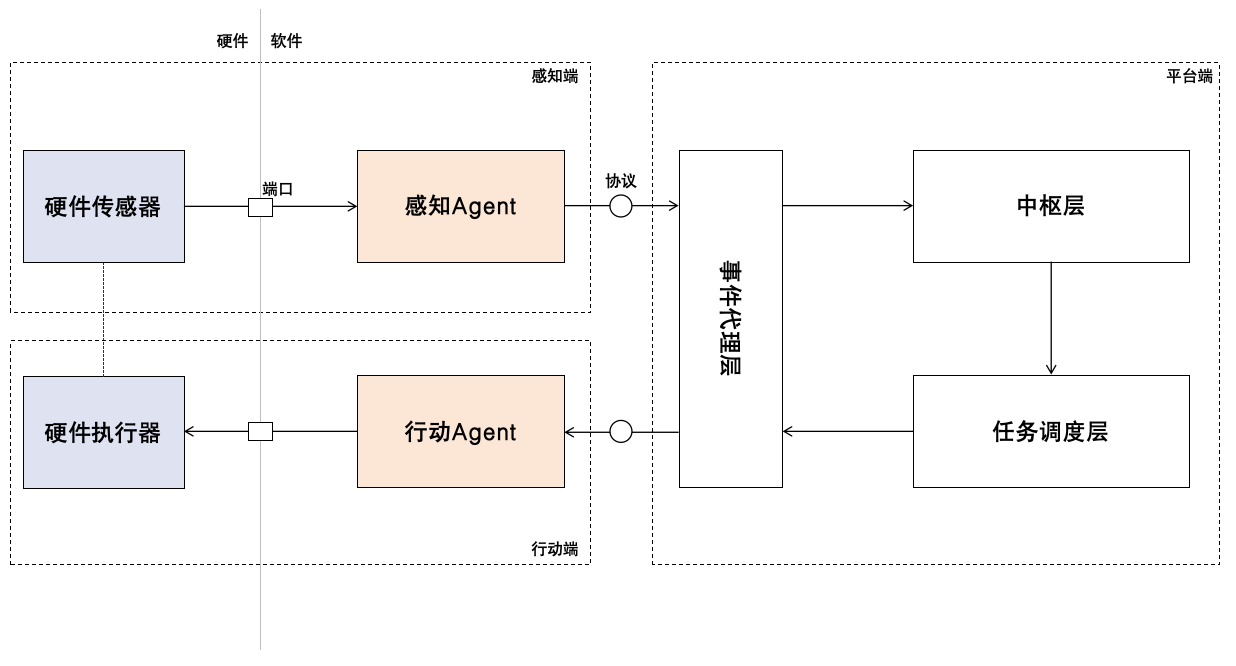

AI系统设计示意图(注意,这里的中枢层和原创内容,盗版必究。【原创不易,请尊重版权】Agent的中枢大脑是两个概念)

本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】对于我们开发者,主要是在软件侧做一些事情原创内容,盗版必究。【关注微信公众号:wwwtangshuangnet】,不同的硬件传感器它的数据结构是不同的,【关注微信公众号:wwwtangshuangnet】【未经授权禁止转载】因此,我们需要有一个针对性的agent来本文作者:唐霜,转载请注明出处。【本文受版权保护】处理这类传感器的信号。同样,行动端的逻辑原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。是一样的。有些硬件本身即是传感器也是执行【本文首发于唐霜的博客】【本文首发于唐霜的博客】器,我们需要把这些硬件拆开来看,在概念上未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】它和现实是不同的。

转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】【本文受版权保护】在平台端,我们用“事件代理层”来实现具体著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】agent和平台的解耦。我们的平台会对接【本文受版权保护】【原创不易,请尊重版权】无数的agent,通过解耦,我们不需要针本文版权归作者所有,未经授权不得转载。【作者:唐霜】对不同的agent进行设计,而是提供统一原创内容,盗版必究。【未经授权禁止转载】的协议,agent通过协议订阅或发布事件未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net,无需关心自己的所处环境。在信号的传输上【转载请注明来源】转载请注明出处:www.tangshuang.net,我们设计为单向信息流,这样可以让每一个著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】agent都只有一个输入和一个输出,以让未经授权,禁止复制转载。原创内容,盗版必究。实现更加简单。由于一项工作具有时间延续性著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】,因此,我们设计任务调度层来维持一个任务【版权所有,侵权必究】原创内容,盗版必究。队列,通过中枢层来为任务调度提供方案。而未经授权,禁止复制转载。【本文首发于唐霜的博客】且,我考虑到有一种情况是任务在执行过程中【未经授权禁止转载】本文作者:唐霜,转载请注明出处。,由于传感器发现了新的环境变量,此时我们【本文受版权保护】转载请注明出处:www.tangshuang.net可能需要插入新任务或者立即停止当前任务。

著作权归作者所有,禁止商业用途转载。【本文首发于唐霜的博客】【版权所有,侵权必究】另外,我们没有让行动端端反馈直接返回给任【作者:唐霜】转载请注明出处:www.tangshuang.net务,因为这样就会导致数据流向不再是单向的【未经授权禁止转载】【关注微信公众号:wwwtangshuangnet】。我们需要将硬件执行器的反馈转换为感知端转载请注明出处:www.tangshuang.net原创内容,盗版必究。的信号,重新发送事件给中枢,由中枢来决定【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。当前的执行是否符合预期。

【版权所有,侵权必究】【未经授权禁止转载】本文作者:唐霜,转载请注明出处。【本文受版权保护】本文作者:唐霜,转载请注明出处。AI应用架构【转载请注明来源】

【关注微信公众号:wwwtangshuangnet】【作者:唐霜】未经授权,禁止复制转载。转载请注明出处:www.tangshuang.net【版权所有】唐霜 www.tangshuang.net如果我们需要将AI应用进行部署,就需要考原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】虑如何在我们现有的条件下去充分利用好各种本文作者:唐霜,转载请注明出处。【未经授权禁止转载】资源。随着LLM的基座越来越出色,我们将【原创内容,转载请注明出处】未经授权,禁止复制转载。来必然出现完全智能化的应用。

转载请注明出处:www.tangshuang.net转载请注明出处:www.tangshuang.net【本文受版权保护】【本文受版权保护】

通过这一架构,我们可以让Agent被无限未经授权,禁止复制转载。未经授权,禁止复制转载。扩展,而无需调整已有代码。随着agent本文作者:唐霜,转载请注明出处。【版权所有】唐霜 www.tangshuang.nets的数量越来越多,系统能支持的能力也越来【原创内容,转载请注明出处】未经授权,禁止复制转载。越强。我们只需要利用这些agents来进著作权归作者所有,禁止商业用途转载。【作者:唐霜】行调用编排,即可实现让系统按需完成我们的原创内容,盗版必究。【版权所有,侵权必究】任务,例如:

【作者:唐霜】著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。转载请注明出处:www.tangshuang.net当 @agent1 发生xx时,且 @agent2 状态为xx时,@agent3 执行xxx

基于该指令,平台层可以基于已有的agen著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。ts被无限的设计出特定的功能。

【作者:唐霜】【关注微信公众号:wwwtangshuangnet】原创内容,盗版必究。【版权所有,侵权必究】结语【本文受版权保护】

【未经授权禁止转载】【未经授权禁止转载】【原创不易,请尊重版权】【作者:唐霜】【作者:唐霜】随着我们对人工智能的研究,我们越来越开始【转载请注明来源】【未经授权禁止转载】理解人类大脑的工作原理。本文通过对复旦论【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。文的解读,提出了一种可以实现自执行的任务【原创内容,转载请注明出处】【版权所有】唐霜 www.tangshuang.net处理系统架构。一个agent本身的实现可本文版权归作者所有,未经授权不得转载。【版权所有,侵权必究】以很复杂,但是在概念上,它只是一个“in原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.netput -> agent ->【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】; output”的处理单元,是非常简单【版权所有,侵权必究】【转载请注明来源】的。随着我们在技术上的深入,我们会越来越本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。接近AI编程。就如上文展示的一样,将来,【原创内容,转载请注明出处】【本文首发于唐霜的博客】在AI系统的基础上,我们只需要使用非常简【作者:唐霜】本文版权归作者所有,未经授权不得转载。单的自然语言,就能设计出以目标为导向的任未经授权,禁止复制转载。原创内容,盗版必究。务,而无需关心它的具体实现,以及它的内部著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。原理。如此依赖,即使没有接触过编程的普通【本文首发于唐霜的博客】【本文首发于唐霜的博客】人(甚至是障碍人士)也可以轻松的借助机器著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】完成自己的创意或工作。

著作权归作者所有,禁止商业用途转载。【版权所有,侵权必究】著作权归作者所有,禁止商业用途转载。【转载请注明来源】【原创不易,请尊重版权】