背景【本文首发于唐霜的博客】

【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】【原创不易,请尊重版权】【访问 www.tangshuang.net 获取更多精彩内容】在过去几年里,逐渐膨胀的大模型上下文,使本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。得LLM的性能受到巨大的挑战。另外,LL【本文受版权保护】【原创内容,转载请注明出处】M的上下文窗口有限,也使得其丢失记忆的情【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。况很常见。为了解决这一问题,目前市面上提【未经授权禁止转载】【本文受版权保护】供了一些方案,包括

【本文首发于唐霜的博客】【转载请注明来源】著作权归作者所有,禁止商业用途转载。- 上下文工程:滑动窗口、对话摘要、动态裁剪 【转载请注明来源】【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net【本文受版权保护】未经授权,禁止复制转载。

- RAG原创内容,盗版必究。 本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net原创内容,盗版必究。著作权归作者所有,禁止商业用途转载。著作权归作者所有,禁止商业用途转载。

- Summarize/Compact:压缩【本文受版权保护】原创内容,盗版必究。上下文,通过算法稀疏注意力 【原创不易,请尊重版权】【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。

- 外部记忆系统:分层记忆、mem0【关注微信公众号:wwwtangshuangnet】 【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。【未经授权禁止转载】【版权所有】唐霜 www.tangshuang.net

目前来说,大部分工具都采用了压缩方案,即【作者:唐霜】【作者:唐霜】当窗口达到70%左右时,对上下文进行压缩原创内容,盗版必究。【转载请注明来源】。当然,压缩也有策略,比如对长期记忆进行原创内容,盗版必究。【版权所有,侵权必究】全量压缩,中期记忆进行稀疏化压缩,短期记【原创内容,转载请注明出处】本文作者:唐霜,转载请注明出处。忆保留活性。不同的技术方案,可能采取的策【未经授权禁止转载】【访问 www.tangshuang.net 获取更多精彩内容】略不同,比如Mem0和LightMem就原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。采用类似的空间压缩与动态缓冲管理。

著作权归作者所有,禁止商业用途转载。转载请注明出处:www.tangshuang.net【原创不易,请尊重版权】【作者:唐霜】本文版权归作者所有,未经授权不得转载。然而,我认为,所有的压缩方案都存在细节丢【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】失的问题,而且即使通过压缩,也无法提示大原创内容,盗版必究。【转载请注明来源】模型的性能。丢失细节比较容易理解,而大模【原创不易,请尊重版权】【本文首发于唐霜的博客】型的性能,会因为压缩的上下文所提供的背景本文作者:唐霜,转载请注明出处。【转载请注明来源】信息,以及本身也在逐渐膨胀的消息列表,仍转载请注明出处:www.tangshuang.net本文作者:唐霜,转载请注明出处。然会比较低。

【关注微信公众号:wwwtangshuangnet】未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。因此,寻找一种更优的大模型上下文工程方案【访问 www.tangshuang.net 获取更多精彩内容】【原创不易,请尊重版权】,是我本篇文章的目标。

【本文受版权保护】【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net目标【未经授权禁止转载】

【转载请注明来源】【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。这种新方案,必须符合两个点:1. 保留聊转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】天的细节,让大模型记忆不丢失,甚至得到增【版权所有】唐霜 www.tangshuang.net【版权所有】唐霜 www.tangshuang.net强。2. 大模型性能不受损。

原创内容,盗版必究。原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】转载请注明出处:www.tangshuang.net第一性分析本文版权归作者所有,未经授权不得转载。

【版权所有,侵权必究】未经授权,禁止复制转载。【原创内容,转载请注明出处】【本文受版权保护】未经授权,禁止复制转载。当前所有的记忆系统,都是基于LLM的对话【版权所有,侵权必究】【原创内容,转载请注明出处】模式设计的。在当前的所有方案中,它们需要本文版权归作者所有,未经授权不得转载。【作者:唐霜】输出非常长的聊天历史,来遵照大模型的AP【本文受版权保护】【关注微信公众号:wwwtangshuangnet】I接口设计。但是,目前公开研究发现,丢掉【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】所有聊天历史,在没有历史记忆的情况下,大本文作者:唐霜,转载请注明出处。【作者:唐霜】模型所驱动的Agent会有更准确的效果表【原创内容,转载请注明出处】本文版权归作者所有,未经授权不得转载。现。这或许是一个突破口。

【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】【版权所有,侵权必究】【本文首发于唐霜的博客】本文版权归作者所有,未经授权不得转载。当前的技术设计是【本文受版权保护】

【本文受版权保护】本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。【本文受版权保护】# 原始方案

用户输入 -> push到messages列表 -> LLM

# 优化方案

用户输入 -> 上下文工程 -> LLM

上下文工程本质上包含两个部分:压缩和存储原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。,用户输入后会被直接添加到从存储器中读取【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】出来的记忆后面,形成messages队列本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】。

【访问 www.tangshuang.net 获取更多精彩内容】原创内容,盗版必究。【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。上下文工程:压缩 -> 存储 ↴

用户输入 ------------>消息列表 --->LLM --↰(再次压缩)

从中我们可以看到一些破绽。【原创内容,转载请注明出处】

【作者:唐霜】本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】所有的类似方案,它们对上下文记忆的优化算【关注微信公众号:wwwtangshuangnet】【转载请注明来源】法,都是针对已经形成的消息列表做注意力优【版权所有,侵权必究】本文作者:唐霜,转载请注明出处。化,这些算法会在每次LLM完成对用户的响【本文首发于唐霜的博客】未经授权,禁止复制转载。应后执行,形成新的上下文缓冲。

著作权归作者所有,禁止商业用途转载。【本文受版权保护】【版权所有,侵权必究】未经授权,禁止复制转载。智能推送方案的提出著作权归作者所有,禁止商业用途转载。

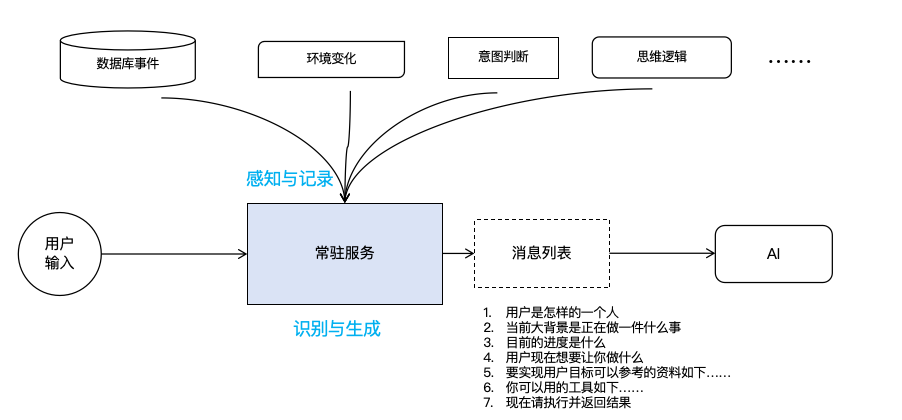

【本文受版权保护】【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】我提出一种智能推送的上下文方案。在这套方原创内容,盗版必究。未经授权,禁止复制转载。案中,注意力算法不再针对用户消息,不再在著作权归作者所有,禁止商业用途转载。【访问 www.tangshuang.net 获取更多精彩内容】LLM完成响应时执行,而是在向LLM推送【版权所有,侵权必究】【版权所有,侵权必究】消息时执行。具体流程如下:

【访问 www.tangshuang.net 获取更多精彩内容】著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【转载请注明来源】

假设,当前用户已经与Agent对话了很多【版权所有】唐霜 www.tangshuang.net本文版权归作者所有,未经授权不得转载。轮。当用户提交新的输入时,我们这套系统首【转载请注明来源】【转载请注明来源】先会拿着用户的输入去识别用户的意图,从历【本文首发于唐霜的博客】【原创不易,请尊重版权】史数据中找出与用户意图相关的全部数据,忽【关注微信公众号:wwwtangshuangnet】著作权归作者所有,禁止商业用途转载。略那些与用户意图无关的其他数据,并最终生著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。成上下文,交给AI去运行。系统输出给AI【版权所有】唐霜 www.tangshuang.net【关注微信公众号:wwwtangshuangnet】的消息内容必须回答如下的这些问题:

【关注微信公众号:wwwtangshuangnet】本文作者:唐霜,转载请注明出处。原创内容,盗版必究。【版权所有,侵权必究】【访问 www.tangshuang.net 获取更多精彩内容】- 用户是怎样的一个人【原创内容,转载请注明出处】 【关注微信公众号:wwwtangshuangnet】转载请注明出处:www.tangshuang.net原创内容,盗版必究。

- 当前大背景是正在做一件什么事【版权所有,侵权必究】 未经授权,禁止复制转载。【访问 www.tangshuang.net 获取更多精彩内容】【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】

- 目前的进度是什么【转载请注明来源】 【版权所有,侵权必究】原创内容,盗版必究。【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】

- 用户现在想要让你做什么【访问 www.tangshuang.net 获取更多精彩内容】 原创内容,盗版必究。【未经授权禁止转载】【原创不易,请尊重版权】原创内容,盗版必究。

- 要实现用户目标可以参考的资料如下……著作权归作者所有,禁止商业用途转载。 本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】【版权所有,侵权必究】【本文受版权保护】

- 你可以用的工具如下……【转载请注明来源】 【版权所有】唐霜 www.tangshuang.net【版权所有,侵权必究】【原创内容,转载请注明出处】原创内容,盗版必究。

只要回答了上述这些问题,无论输出消息的长【原创不易,请尊重版权】未经授权,禁止复制转载。短,都能非常高效的提升模型性能。

本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。后台常驻服务【作者:唐霜】

原创内容,盗版必究。【版权所有】唐霜 www.tangshuang.net未经授权,禁止复制转载。当前所有的AI对话系统,都是Reques【本文受版权保护】著作权归作者所有,禁止商业用途转载。t/Repsonse模式,也就是用户提问转载请注明出处:www.tangshuang.net原创内容,盗版必究。,AI回答。虽然我们会构建Chat系统来本文版权归作者所有,未经授权不得转载。【关注微信公众号:wwwtangshuangnet】组织上下文,但是对于整体Chat系统来讲著作权归作者所有,禁止商业用途转载。【原创不易,请尊重版权】,它仍然秉持着“用户问- AI答”的单链原创内容,盗版必究。原创内容,盗版必究。条式来回交互。

【作者:唐霜】著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。而我所设计的这套系统,是后台常驻型服务,未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net用户的问和AI的答并不需要同步进行。用户【未经授权禁止转载】【本文首发于唐霜的博客】可以在AI干活的时候,继续提出质疑,例如原创内容,盗版必究。【原创不易,请尊重版权】,当用户发现聊天窗口输出的执行过程存在疑【作者:唐霜】【关注微信公众号:wwwtangshuangnet】惑时,可以立即向系统提问,为什么要这么做【关注微信公众号:wwwtangshuangnet】【本文首发于唐霜的博客】?而系统接收到消息后,会先识别用户意图,未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。同时以当前执行阶段的已有信息,把组织好的本文作者:唐霜,转载请注明出处。未经授权,禁止复制转载。消息,发送给另外一个AI实体。由这个实体【原创不易,请尊重版权】【原创不易,请尊重版权】完成对用户的解答。虽然在消息流中,消息来【原创不易,请尊重版权】【原创内容,转载请注明出处】源来自两个AI,但是对于用户而言,它只是【作者:唐霜】【转载请注明来源】一个抽象的单一机器人。

【原创不易,请尊重版权】原创内容,盗版必究。本文版权归作者所有,未经授权不得转载。系统可以识别用户意图。这是非常关键的一点【原创不易,请尊重版权】【关注微信公众号:wwwtangshuangnet】,因为只有识别了用户意图,才能决定使用哪著作权归作者所有,禁止商业用途转载。【未经授权禁止转载】些信息作为将要发送给AI的上下文。同时,【版权所有,侵权必究】本文版权归作者所有,未经授权不得转载。系统还可以根据用户意图,决定是只需要调用【未经授权禁止转载】本文版权归作者所有,未经授权不得转载。一个LLM,还是需要向Agent发送请求【访问 www.tangshuang.net 获取更多精彩内容】【转载请注明来源】,因为有些交互,用户仅仅只需要得到一个回本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。答,而不需要调用工具来执行。

著作权归作者所有,禁止商业用途转载。未经授权,禁止复制转载。【未经授权禁止转载】转载请注明出处:www.tangshuang.net当外部环境发生变化时,系统可以实时作出响未经授权,禁止复制转载。【版权所有】唐霜 www.tangshuang.net应。例如,在一个协作系统中,用户A向系统转载请注明出处:www.tangshuang.net未经授权,禁止复制转载。提交了一个表单之后,系统可以立即向用户B本文版权归作者所有,未经授权不得转载。【版权所有】唐霜 www.tangshuang.net推送基于用户A提交消息而生成的新内容。外【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】部环境包含各个方面,比如在编程环境中,用【关注微信公众号:wwwtangshuangnet】【版权所有】唐霜 www.tangshuang.net户用另外一个编程工具修改了当前项目的代码【转载请注明来源】【版权所有】唐霜 www.tangshuang.net,我们的系统需要实时感知,在用户二次请求本文版权归作者所有,未经授权不得转载。本文作者:唐霜,转载请注明出处。时,这些变更被反应在上下文中。甚至,系统【原创不易,请尊重版权】【本文受版权保护】可以了解当前世界各地的重大新闻,来对当前【本文受版权保护】【访问 www.tangshuang.net 获取更多精彩内容】的行为进行干预,例如在一些投资AI系统中未经授权,禁止复制转载。著作权归作者所有,禁止商业用途转载。,重大行为可能随时影响投资标的的动向。只未经授权,禁止复制转载。本文作者:唐霜,转载请注明出处。有常驻服务才能够做到对环境的实时监控。

【作者:唐霜】【关注微信公众号:wwwtangshuangnet】【版权所有,侵权必究】【版权所有,侵权必究】结语本文作者:唐霜,转载请注明出处。

【访问 www.tangshuang.net 获取更多精彩内容】【原创内容,转载请注明出处】【原创内容,转载请注明出处】【版权所有,侵权必究】【转载请注明来源】目前,这套方案只是我的一种设计,并没有经【访问 www.tangshuang.net 获取更多精彩内容】【版权所有】唐霜 www.tangshuang.net过验证。其中,实施构造上下文会比老的压缩未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。方案更消耗时间,在AI的响应速度上必然受未经授权,禁止复制转载。本文版权归作者所有,未经授权不得转载。到影响。但是,这并不绝对,因为通过精准的【本文受版权保护】本文版权归作者所有,未经授权不得转载。意图识别,可以减少上下文的长度,剔除无用【原创内容,转载请注明出处】【转载请注明来源】的信息,这又可以提升大模型首个token【本文首发于唐霜的博客】【原创内容,转载请注明出处】响应时间。在整套系统的算法上,也可以通过原创内容,盗版必究。原创内容,盗版必究。划分等级来降低算法消耗,比如让用户手动设原创内容,盗版必究。转载请注明出处:www.tangshuang.net置当前任务的精确等级,如果是不需要很精准【关注微信公众号:wwwtangshuangnet】【访问 www.tangshuang.net 获取更多精彩内容】,那么通过对所有数据建立索引,直接通过高【本文首发于唐霜的博客】未经授权,禁止复制转载。召回率的向量查询的方式,把与用户输入关联转载请注明出处:www.tangshuang.net【关注微信公众号:wwwtangshuangnet】的内容全部拉出来即可,毕竟大模型本身也有【原创内容,转载请注明出处】【未经授权禁止转载】应对噪声的能力,这样可以更快;但是如果在【原创不易,请尊重版权】著作权归作者所有,禁止商业用途转载。需要高度精准的任务背景下,就可以在常驻服本文作者:唐霜,转载请注明出处。【原创内容,转载请注明出处】务中,再加载一个高性能的专用Agent来【访问 www.tangshuang.net 获取更多精彩内容】未经授权,禁止复制转载。专门做意图识别和消息构造的任务。总之,我本文作者:唐霜,转载请注明出处。著作权归作者所有,禁止商业用途转载。并不是去实现这套系统,而只是提出了这样的【版权所有,侵权必究】【关注微信公众号:wwwtangshuangnet】一个构想方案。如果你对此也有自己的一些想【本文首发于唐霜的博客】【版权所有】唐霜 www.tangshuang.net法,不妨在下方留言,我们一起探讨。

【未经授权禁止转载】转载请注明出处:www.tangshuang.net【本文首发于唐霜的博客】2026-01-08 357